Hirn-Computer-gesteuerte adaptive Virtuelle Realität zur Integration von Emotionen in die Interaktionen zwischen Mensch und Maschine (EmoAdapt)

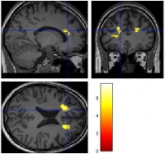

Manuelle Dateneingaben (und teilweise Sprache oder Bewegungserkennung) bestimmen derzeit überwiegend die Mensch-Maschine-Interaktion. Faktoren wie Ablehnung, Stress, Begeisterung oder reduzierte Aufmerksamkeit durch Müdigkeit oder Ablenkung können die Interaktion zwar stark beeinflussen, werden aber von einer Maschine nicht erkannt. Sie kann daher nicht auf Veränderungen reagieren. Im Projekt EmoAdapt werden zunächst mit neuesten Methoden der Hirnbildgebung Muster aktivierter Hirnareale bei verschiedenen Emotionen und Dispositionen aufgenommen und zugeordnet. Anschließend wird über Hirn-Computer-Schnittstellen die Hirnaktivierung während einer Interaktion gemessen. Hierzu wird Echtzeit-Magnetresonanztomographie (rt-fMRT) bei 7T und 3T, EEG und simultane rt-fMRT/EEG verwendet. Dies soll dem Computer ermöglichen, in Echtzeit innerhalb einer simulierten Welt (Virtual Reality) auch komplexe Interaktionen an das momentane Befinden des Nutzers anzupassen. Hierzu werden neue Strategien entwickelt werden, um in der Interaktion Mensch-Maschine neurobiologisch fundierte Parameter für Emotionen (z.B. Pulsrate) einzubeziehen. Ethische, rechtliche und datenschutzrelevante Fragen werden als wichtige Aspekte in die Untersuchung einbezogen.

Das Projekt ist ein Kooperationsprojekt zwischen der Otto-von-Guericke-Universität Magdeburg (Projektleiter Prof. Dr. Dr. J. Bernarding, Institut für Biometrie und Medizinische Informatik (IBMI), Teilprojektleiterin PD Dr. K. Krauel, Klinik für Psychiatrie, Psychosomatik und Psychotherapie des Kindes- und Jugendalters (KKJP); Teilprojektleiterin Prof. Dr. E. Brinkschulte, Fachbereich Geschichte, Ethik und Theorie der Medizin, (GET)) sowie dem Leibniz-Institut für Neurobiologie, Magdeburg (Projektleiter Dr. A. Brechmann).

Projektlaufzeit: 1. Mai 2015 - 30. April 2018